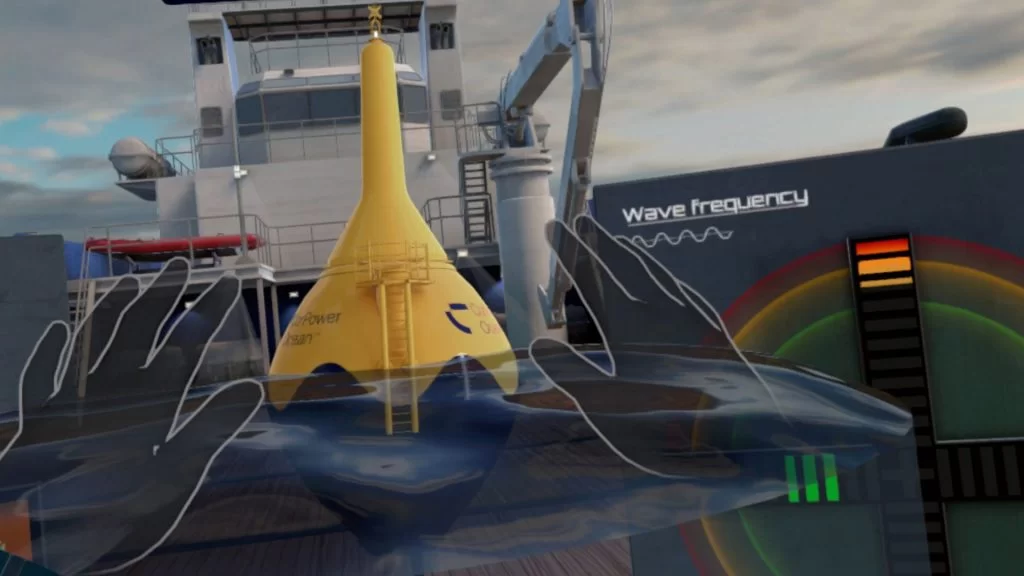

Extended Reality (XR) verwischt mit Hilfe realistischer Grafiken zunehmend die Grenzen zwischen Realität und Virtualität. Die Erstellung lebensechter Visuals ist jedoch ein komplexer Prozess, der geeignete Hardware, Kenntnisse von Rendering-Techniken sowie sorgfältige Aufmerksamkeit für Design- und Materialdetails erfordert. Dieser Artikel untersucht die Elemente, die zur Erstellung realistischer XR-Visuals beitragen – darunter Auflösung, Maßstab, Materialien, Beleuchtung und Optimierungstechniken. Durch die Anwendung dieser Erkenntnisse, praxisnaher Tipps und realer Beispiele können 3D-Enthusiast*innen das Nutzererlebnis ihrer XR-Anwendungen auf ein neues Niveau heben.

Gerätespezifikationen

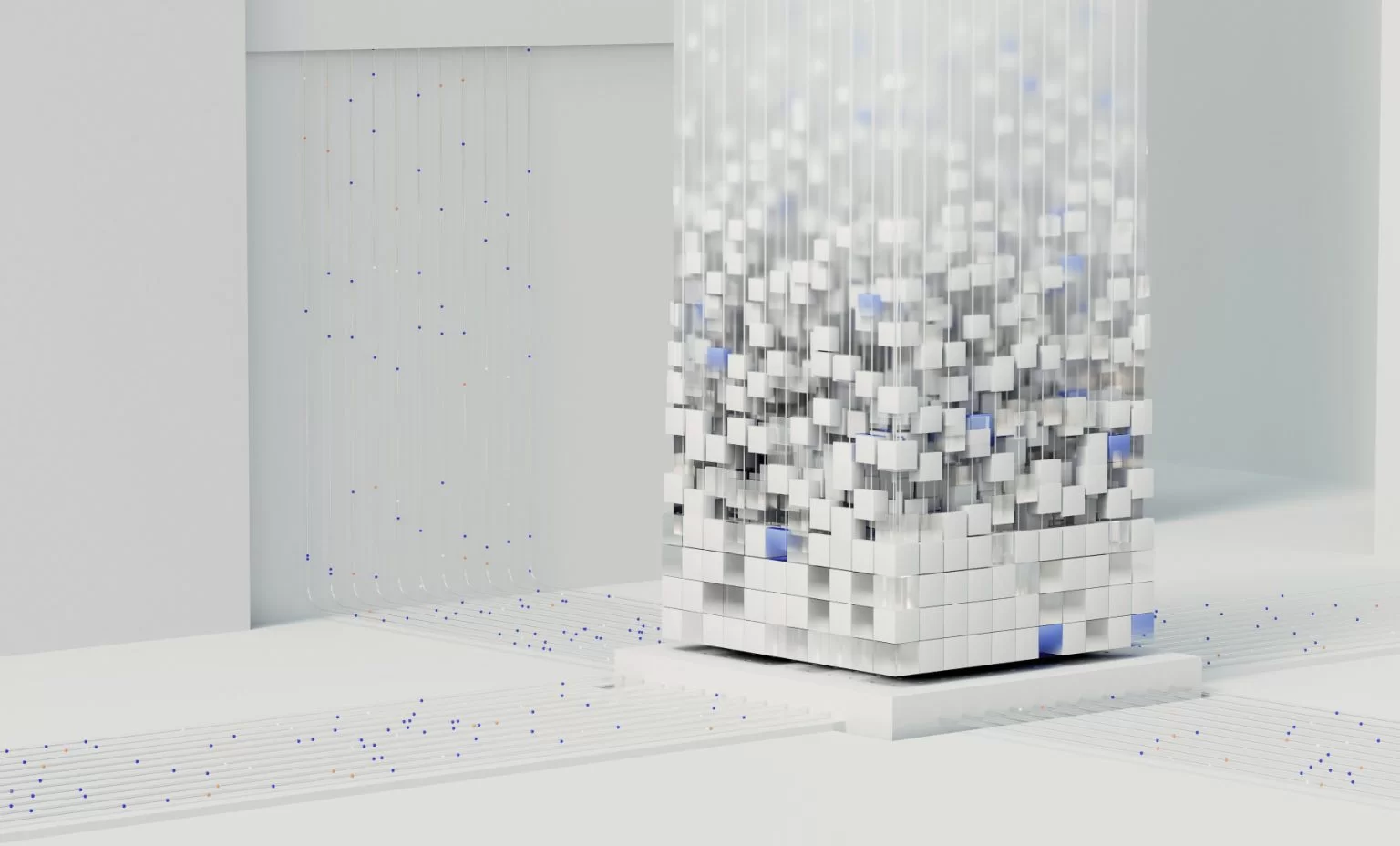

Im Bereich Virtual Reality (VR) und Mixed Reality (MR) spielen Auflösung und Display-Technologie eine entscheidende Rolle für realistische Visuals. Die Qualität des visuellen Nutzererlebnisses hängt stark von der Pixeldichte des Displays ab. Höhere Auflösungen helfen, den unerwünschten “Screen-Door-Effekt” zu reduzieren – ein häufiges Problem, bei dem Nutzerinnen ein netzartiges Muster über dem Bild wahrnehmen, das die Immersion stört.

llustration des „Screen-Door-Effekts“ in VR: Vergleich von Visuals mit niedriger Auflösung (mit Effekt) und hoher Auflösung (ohne Effekt)

Um die visuelle Wiedergabetreue weiter zu verfeinern, integrieren modernste Geräte ausgeklügelte Rendering-Techniken. Eine solche Innovation ist das foveated rendering. Diese Technologie passt den Rendering-Fokus intelligent an, indem sie hochauflösende Grafiken dort konzentriert, wo der Blick der Nutzer*innen gerichtet ist. Auf diese Weise werden Leistung optimiert und gleichzeitig eine makellose visuelle Qualität beibehalten.

An die individuellen Vorlieben angepasst, können Nutzer*innen aus einer Vielzahl von Geräten wählen, die jeweils mit hochwertigen Bildschirmen und leistungsstarker Hardware ausgestattet sind. Diese Vielfalt ermöglicht es ihnen, die Option auszuwählen, die am besten zu ihren spezifischen Anforderungen passt, und so ihr Virtual-Reality-Erlebnis zu verbessern. Im Bereich der Mixed Reality (MR) spielen Kameras eine zentrale Rolle. Optische und Infrarotkameras erfassen die reale Welt und ermöglichen es den Geräten, digitale Inhalte nahtlos in die Umgebung der Nutzer*innen zu integrieren. Mit der Weiterentwicklung der Kameratechnologie werden MR-Erlebnisse eine verbesserte Tiefenwahrnehmung, Objekterkennung und ein besseres Umgebungsverständnis bieten. Folglich wird ein solch immersives Erlebnis noch realistischer.

Der Maßstab virtueller Welten

Ein oft übersehener Aspekt bei der Erstellung realistischer Visuals ist der Maßstab von 3D-Modellen. Ein korrekter Maßstab ist entscheidend, um ein authentisches Erlebnis zu gewährleisten. In virtuellen Umgebungen interagieren Nutzer*innen mit Objekten und Räumen, die den realen Proportionen entsprechen müssen. Eine falsche Einschätzung des Maßstabs von 3D-Modellen kann zu Desorientierung führen und die Illusion der Immersion zerstören. Um dies zu vermeiden, müssen Entwicklerinnen und Designerinnen die Größe virtueller Objekte und Umgebungen sorgfältig kalibrieren, sodass sie der menschlichen Wahrnehmung und dem Kamerawinkel des Geräts entsprechen. Dieser Ansatz stellt sicher, dass Nutzer*innen eine echte Präsenz innerhalb der virtuellen Räume empfinden. Bei Virtual-Reality-(VR)-Anwendungen ist es besonders wichtig, die Komposition sorgfältig zu berücksichtigen, da sich die Nutzerinnen frei innerhalb der virtuellen Räume bewegen können. Das Ziel der Künstlerinnen ist es, ein kohärentes und angenehmes Erlebnis zu schaffen, indem sie das richtige Gleichgewicht zwischen kleinen, mittleren und großen Formen herstellen und visuelle Überfrachtung vermeiden.

Materialien und Details

Materialien sind entscheidend für die Belebung von Extended-Reality-(XR)-Umgebungen, da hochwertige Texturen das Werkzeugset der Künstlerinnen darstellen, um realistische Visuals zu erzeugen. Damit virtuelle Objekte nahtlos in XR-Landschaften integriert werden können, müssen Gestalterinnen auf Oberflächendetails wie Farbverteilung, Reflexionen und Normal Maps achten.

Darüber hinaus tragen prozedurale Generierungstechniken erheblich zur Tiefe und Vielfalt von XR-Umgebungen bei, indem sie die Erstellung komplexer und abwechslungsreicher virtueller Welten ermöglichen.

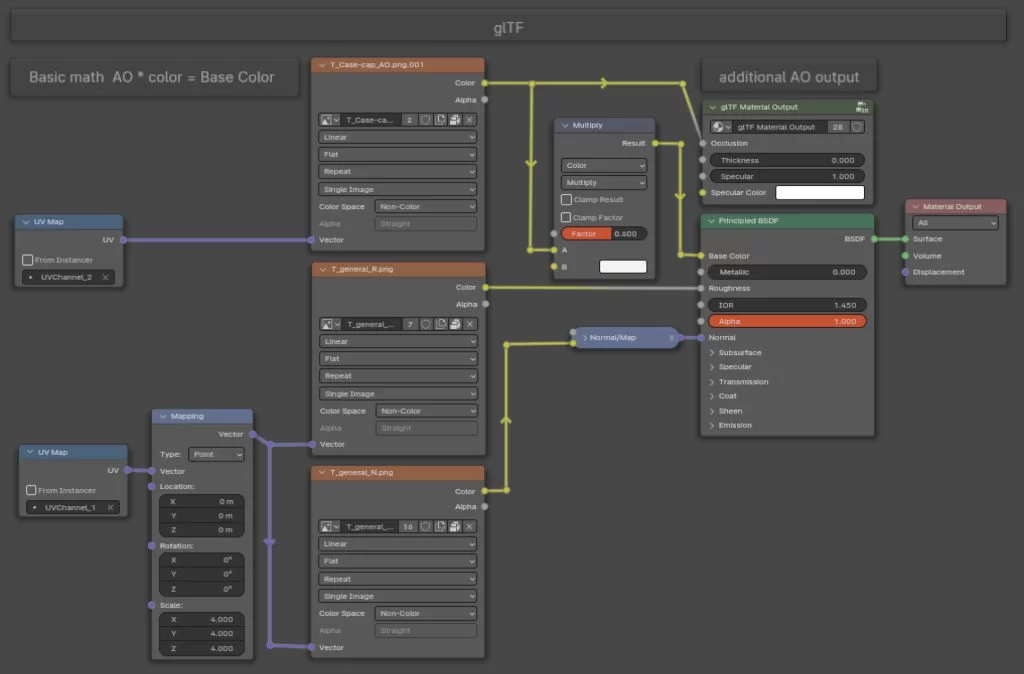

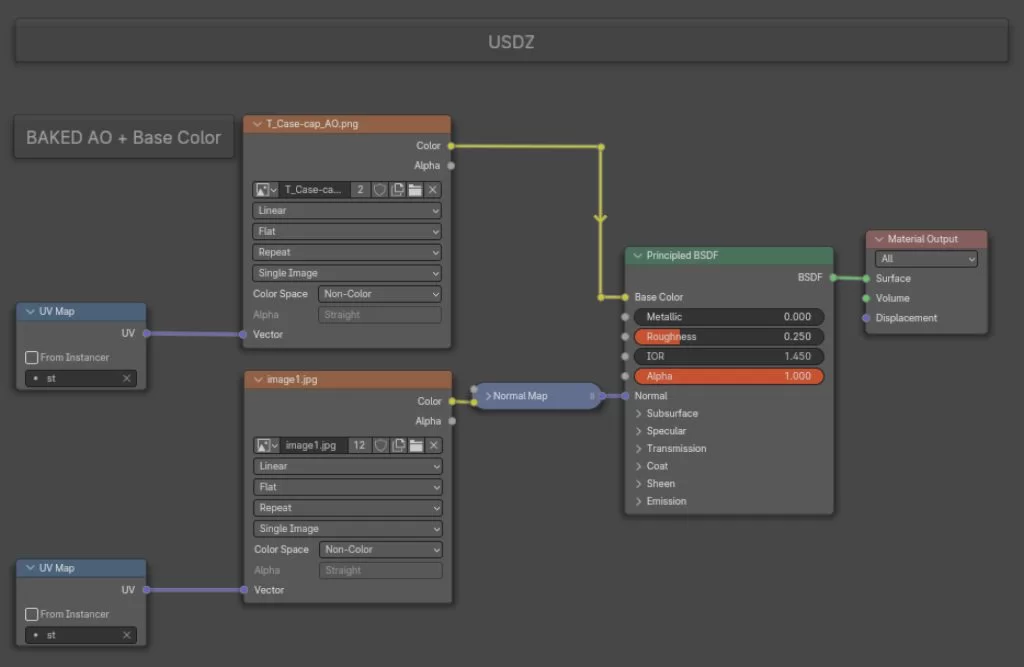

Bei der Entwicklung von Augmented-Reality-(AR)-Anwendungen ist es entscheidend, sich auf die Texturen zu konzentrieren, die in glTF – für Android-AR – und USDZ – für iOS-AR – Formate eingebunden werden können. Das USDZ-Format erfordert zusätzlichen Aufwand, um Outputs zu „baken“ und die Anzahl der Texturen zu minimieren. Das glTF-Format hingegen liefert beeindruckende Ergebnisse bei der Verwendung von Material Nodes, wie in den untenstehenden Abbildungen gezeigt. Es ist wichtig zu beachten, dass glTF-Dateien im Allgemeinen eine kleinere Dateigröße haben als USDZ-Dateien.

Bei der Arbeit an 3D-Modelling-Aufgaben kann es erforderlich sein, die topologische Komplexität bestimmter Meshes zu erhöhen. Dies ist notwendig, um das gewünschte Maß an Oberflächendetails zu erreichen. Eine effektive Methode hierfür besteht darin, Bevels bei 90-Grad-Winkeln einzubauen und Weighted Normals zu verwenden. Diese Technik behebt Aliasing-Probleme, die entstehen können, wenn sich Pixel bei bestimmten Betrachtungswinkeln stufenweise bewegen. Der Einsatz von Bevels hilft, unregelmäßige Kanten zu beseitigen und Reflexionen zu verbessern, während Weighted Normals eine präzise Ausrichtung mit Normal Maps sicherstellen und damit die visuelle Wiedergabetreue der 3D-Modelle insgesamt erhöhen. Es ist jedoch wichtig zu beachten, dass Normal Maps, die häufig in traditionellen 2D-Screen-Anwendungen genutzt werden, um Oberflächendetails und Tiefe hinzuzufügen, in Virtual-Reality-(VR)-Umgebungen nicht dasselbe Erlebnis bieten. In VR ist die Wahrnehmung von Tiefe und Details aufgrund der immersiven Natur des Erlebnisses anders. Daher ist es bei der Planung und Gestaltung von VR-Inhalten entscheidend, die meisten großen und mittleren Details direkt in das Mesh zu übertragen.

Beleuchtung

In Extended Reality (XR) erfordert die Erstellung realistischer Visuals den effektiven Einsatz von Beleuchtung, wobei Schatten eine der Säulen des Realismus darstellen. Leider bringt dieses Vorhaben aufgrund der begrenzten Leistungsfähigkeit von Geräten Performance-Herausforderungen mit sich und erfordert eine stärkere Bildschirmerweiterung.

Als praktische Lösung, um sowohl Realismus als auch Performance zu berücksichtigen, ist es notwendig, eine vorläufige Berechnung der Beleuchtung vorzunehmen.

Eine der Techniken ist das Light Baking innerhalb der Game Engine. Dabei handelt es sich um ein Verfahren, bei dem Beleuchtungsberechnungen vorab berechnet und in speziellen Texturen gespeichert werden. Auf diese Weise wird die Rechenlast zur Laufzeit reduziert. Dieser Ansatz ist besonders nützlich in VR- und AR-Anwendungen, bei denen Echtzeit-Rendering entscheidend ist. Durch Light Baking können Entwickler*innen visuell hochwertige Erlebnisse mit Global Illumination bereitstellen, die sowohl flüssig als auch reaktionsschnell sind – und damit die visuelle Wiedergabetreue mit den betrieblichen Einschränkungen der XR-Technologien in Einklang bringen.

Eine weitere Methode, Beleuchtung in 3D-Anwendungen zu integrieren, besteht darin, sie direkt auf Base-Color-Maps einzubrennen. Dies kann zu einer höherwertigen Beleuchtung führen, die in verschiedenen virtuellen Umgebungen genutzt werden kann. Hauptsächlich findet diese Technik in AR- oder Web-Anwendungen Verwendung. Allerdings kann sie beträchtliche Ressourcen erfordern, vor allem aufgrund der Notwendigkeit zahlreicher großer Texturen.

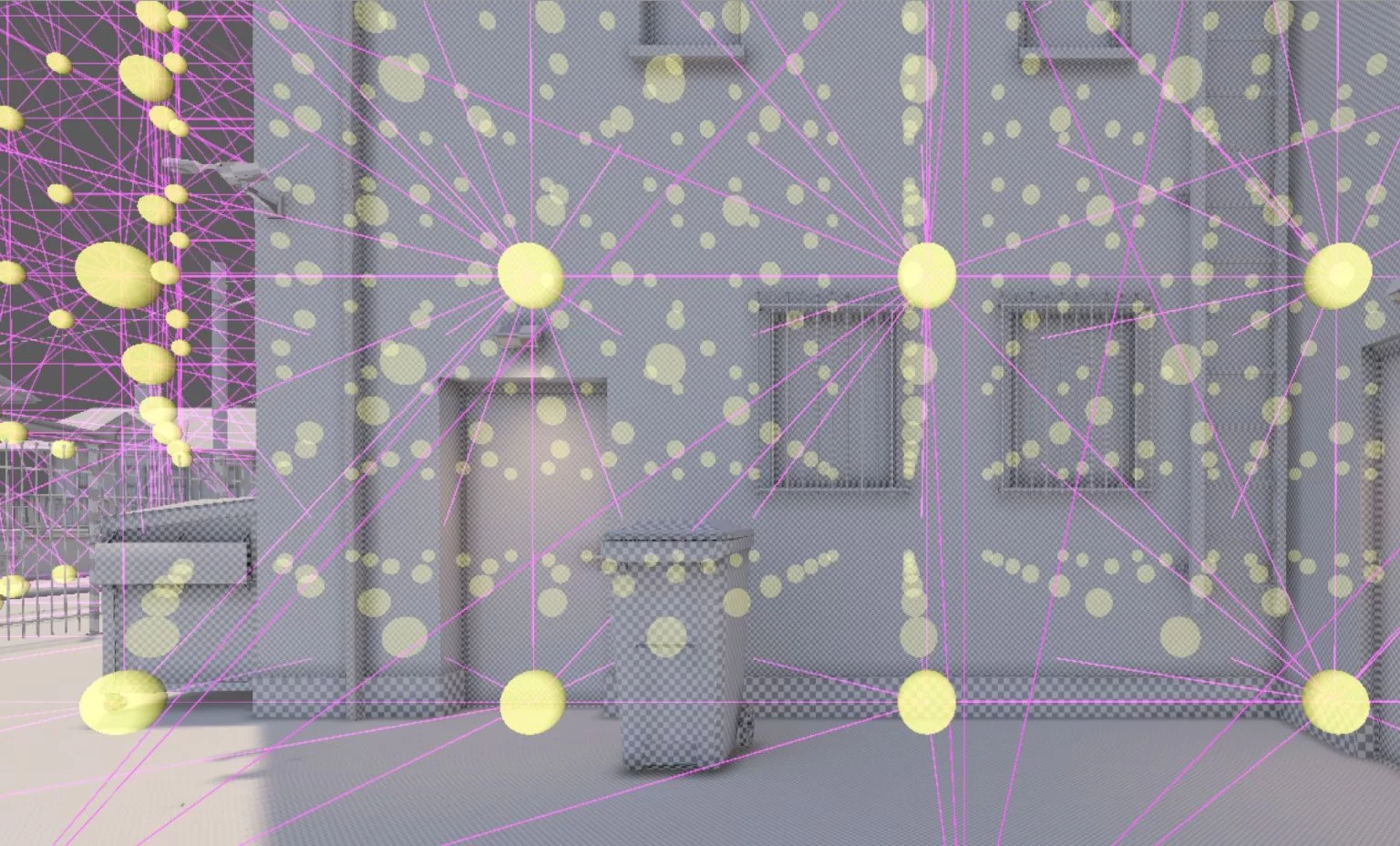

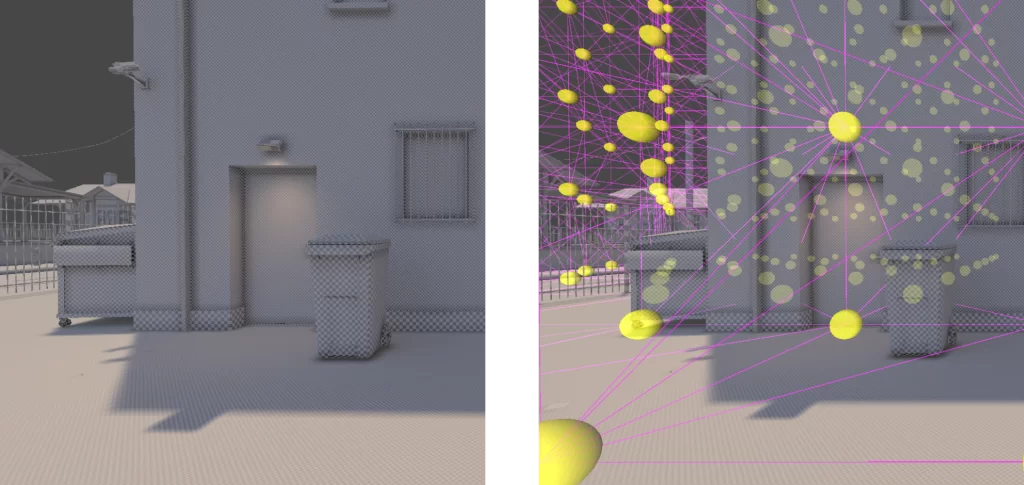

Bei der Entwicklung von Virtual-Reality-(VR)-Anwendungen wird empfohlen, den Lightmap-Baking-Prozess innerhalb der Game Engine zu verwenden. Sollte jedoch der Anwendungsfall vorsehen, dass wir mit der Umgebung interagieren und die Bewegungen anderer Personen sehen, ist es besser, Light Probes einzusetzen.

Der Grund dafür ist, dass Lightmaps statische Texturen erzeugen, die darstellen, wie Licht unter bestimmten Bedingungen mit Oberflächen interagiert. Obwohl Lightmaps eine Beleuchtung von höherer Qualität liefern, verändern sie sich während des Erlebnisses nicht und interagieren nicht mit beweglichen Objekten in der Szene.

Light Probes hingegen ermöglichen es den Nutzer*innen, zu beobachten, wie sich die Farbe von Objekten verändert, wenn sie sich zwischen hellen und dunklen Bereichen bewegen. Außerdem erhöhen sie den Realismus der Szene, indem sie darstellen, wie die Oberfläche beweglicher Objekte mit der direkten Lichtfarbe interagiert.

Illustration von gebackenen Lichtern (Lightmaps) und Light Probes

Optimierungstechniken

Ähnlich wie beim Light Baking sind auch andere Optimierungstechniken entscheidend für die Erstellung realistischer Visuals und eine stabile Performance. Eine davon ist das Level-of-Detail-(LOD)-System, das den Detailgrad von 3D-Modellen dynamisch an die Nähe der Nutzerinnen anpasst und so die Ressourcennutzung optimiert. LOD ist besonders vorteilhaft in großen virtuellen Umgebungen, in denen das Rendern von hochdetaillierten Modellen in der Ferne unnötig sein kann. Wenn sich die Nutzerinnen einem Objekt nähern, wechselt das LOD-System nahtlos zu detailreicheren Modellen und sorgt so für ein Gleichgewicht zwischen visueller Qualität und Rechenleistung. Eine weitere Technik ist das Occlusion Culling, das nur sichtbare Objekte rendert und die Rendering-Last reduziert. Diese Methode ist besonders effektiv in komplexen Szenen, in denen zahlreiche Objekte vorhanden sind, die jedoch nicht alle gleichzeitig sichtbar sind. Durch das intelligente Ausschließen verdeckter Objekte aus den Rendering-Berechnungen trägt dieser Ansatz zu einem flüssigeren und reaktionsschnelleren Erlebnis in Extended-Reality-(XR)-Anwendungen bei. Diese Optimierungstechniken tragen insgesamt zu einem nahtlosen XR-Erlebnis bei, da sie die Leistung steigern, ohne die visuelle Qualität zu beeinträchtigen.

Herausforderungen und zukünftige Entwicklungen

Da sich die XR-Technologie stetig weiterentwickelt, entstehen neue Wege zur Erstellung solcher Anwendungen. Unter den erwarteten zukünftigen Entwicklungen ist das Application Streaming über Cloud-Technologien. Dieser Ansatz streamt Software-Anwendungen von entfernten Servern auf Endgeräte der Nutzer*innen über das Internet und bietet dadurch bessere Grafik, flüssigere Performance und eine geringere Abhängigkeit von lokaler Rechenleistung und Speicherplatz.

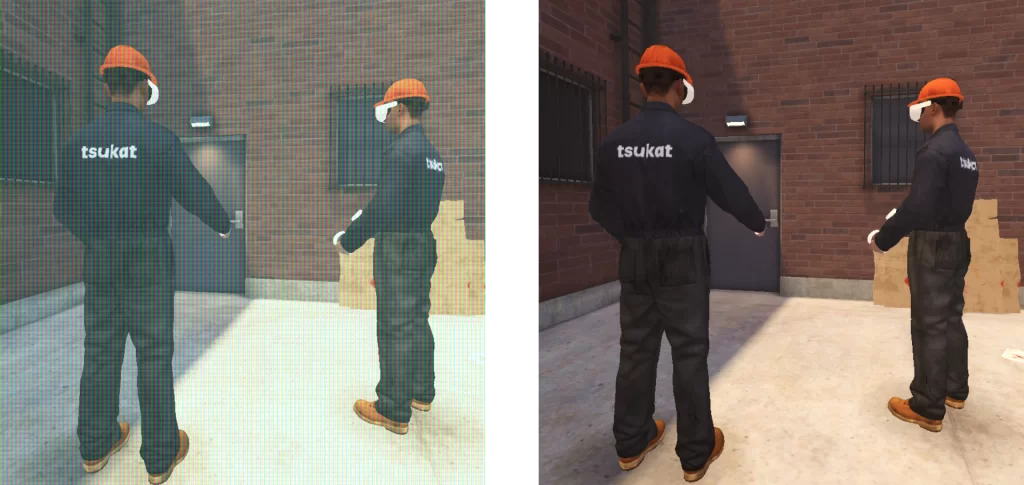

Darüber hinaus steht eine neue Generation von WebGPU bevor, die die nächste Generation von Webanwendungen mit fortschrittlichen Grafiklösungen ermöglicht. Mit direktem Zugriff auf die Graphics Processing Unit (GPU) erleichtert WebGPU verbesserte Rendering-Techniken wie Raytracing, was realistische Beleuchtung und Reflexionen erlaubt. Entwickler*innen können WebGPU für Anwendungen nutzen, die komplexe Simulationen, anspruchsvolle Visualisierungen oder Machine Learning erfordern. Dank dieser Fähigkeiten eignet es sich hervorragend für immersive webbasierte VR- und AR-Erlebnisse. Auch die Hardware spielt eine zentrale Rolle: Die Veröffentlichung der neuesten Versionen von Meta Quest und Vision Pro hat gezeigt, wie stark sich die Kameratechnologie weiterentwickelt hat. Diese Geräte treiben die Entwicklung von Mixed-Reality-(MR)-Anwendungen voran und ermöglichen die nahtlose Integration virtueller Objekte und Schatten in reale Umgebungen.

Illustration des Virtual-Reality-Trainings für Meta Quest

Ein weiterer Aspekt ist das Potenzial von MR-Technologien, virtuelles Training zu verbessern. Durch die Integration von künstlichen Intelligenz-(KI)-Netzwerken wird es möglich sein, vollwertige virtuelle Assistenten zu schaffen. Diese Assistenten können das virtuelle Training durch Funktionen wie personalisierte Anleitung, Echtzeit-Feedback und adaptive Lernerfahrungen, die auf die individuellen Bedürfnisse der Nutzer*innen zugeschnitten sind, erheblich aufwerten.

So können virtuelle Assistenten beispielsweise Leistungsdaten der Nutzer*innen analysieren, Verbesserungspotenziale identifizieren und gezielte Empfehlungen oder Übungen anbieten, um Lernziele effizienter zu erreichen. Die Branche bewegt sich bereits in Richtung einer verstärkten Nutzung von KI-Technologien für virtuelle Trainingszwecke. Dadurch werden diese Umgebungen personalisierter, adaptiver und effektiver.

Fazit

Die Erstellung realistischer Visuals, die die physische und die virtuelle Welt nahtlos miteinander verbinden, erfordert von Künstler*innen größte Sorgfalt. Sie müssen Pixeldichte, Skalierung, Materialauswahl und Beleuchtung berücksichtigen. Mit Blick auf die Zukunft zeigt der Weg von Extended Reality (XR) klar in Richtung cloudbasiertes Application Streaming und die Integration von künstlicher Intelligenz (KI) in Mixed Reality (MR). Diese Innovationen versprechen, die Interaktion mit digitalen Inhalten grundlegend zu verändern und neue Methoden zur Erstellung lebensechter Visuals zu eröffnen.

Bei tsukat, einem Unternehmen für XR- und KI-Entwicklung, sind hochwertige und realistische Visuals untrennbar mit unseren Lösungen verbunden. Die Expertise und das Detailbewusstsein unserer Ingenieurinnen ermöglichen es uns, greifbare Ergebnisse zu liefern – seien es branchenspezifische Trainingssimulationen, bahnbrechende F&E-Lösungen oder innovative Design-Erlebnisse. Erfahren Sie mehr über unsere Leistungen auf unserer Webseite.